Auf einen Blick

3D-Kameras auf Basis von Time-of-Flight PMD-Bildsensoren (Photonic Mixing Device) sind eine kostengünstige Technologie zur aktiven, pixelaufgelösten Entfernungsmessung und bereits Schlüsseltechnologie für Assistenzsysteme in der mobilen Robotik. PMD-Kameras können der störende aber konstante Fremdlichtanteil z.B. des Sonnenlichts besonders effektiv unterdrücken. Jedoch tritt häufig eine unzureichende Genauigkeit bei der Messung der Entfernung, u.a. durch den Einfluss der Reflektivität des Hindernisses, der Interferenz mehrfacher optischer Lichtpfade (Multiple Path Interference) sowie Mischpixeln.

Im Forschungsprojekt 3DRobust (Robuste 3D Stereo-Kamera auf Basis von Time-of-Flight Sensoren zur Verbesserung der Umfeld- und Objekterkennung bei autonomen mobilen Robotern) wird eine neuartige 3D-Kamera entwickelt, die jeweils zwei PMD- und RGB-Sensoren auf Board-Ebene integriert und die nach dem „fail-operational“ Prinzip Entfernungsdaten redundant berechnet. Die Zuverlässigkeit der Entfernungsdaten wird über die Fusion von zwei unterschiedlich generierten Tiefenbildern und RGB Bilder gesteigert. Die Datenfusion soll mittels neuronalen Faltungsnetze (CNN) erfolgen, die speziell im Bereich der maschinellen Bildverarbeitung geeignet sind. Der Kameraprototyp wird für die Anwendung „autonome Steuerung eines autonom fahrenden mobilen Roboters“ im Einsatz erprobt. Insbesondere soll die Zahl falscher Alarme bei der Hinderniserkennung und falscher Objektklassifizierungen reduziert werden.

RWU3D Datensatz

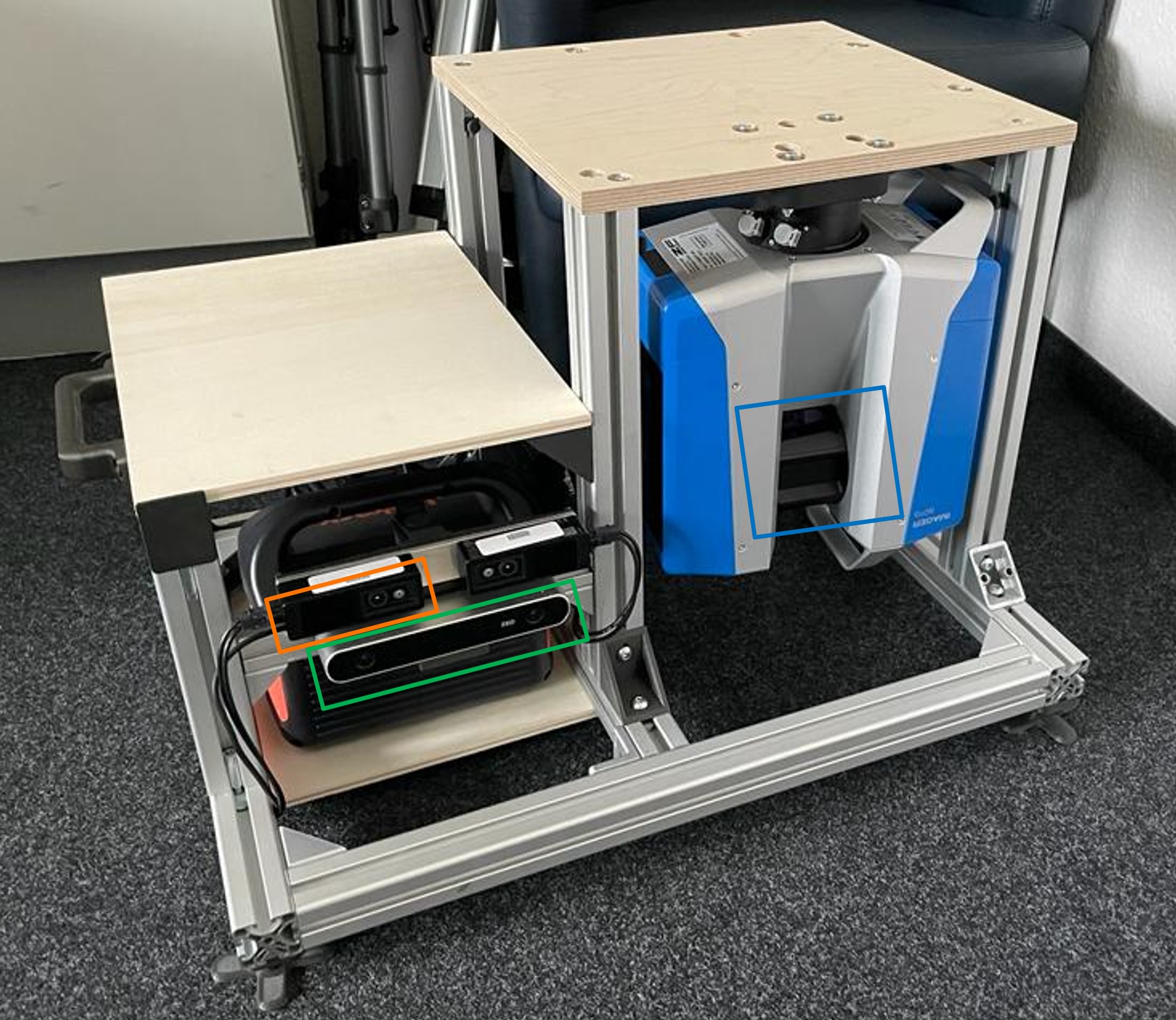

Im Rahmen des Projekts haben wir einen realen Datensatz, RWU3D, erstellt, der die ToF-Daten nach Anwendung der Interpolation sowie RGB-Daten zusammen mit den hochauflösenden Ground-Truth-Daten umfasst. Zur Erfassung des Datensatzes ist unten das vollständig montierte Rig mit dem Z+F 3D-Laserscanner (blau markiert), der O3R ToF-Kamera (orange markiert) und der ZED 2-Stereokamera (grün markiert) zu sehen. Das Bild rechts zeigt das Rig in der Endposition während der Aufnahme einer Szene.

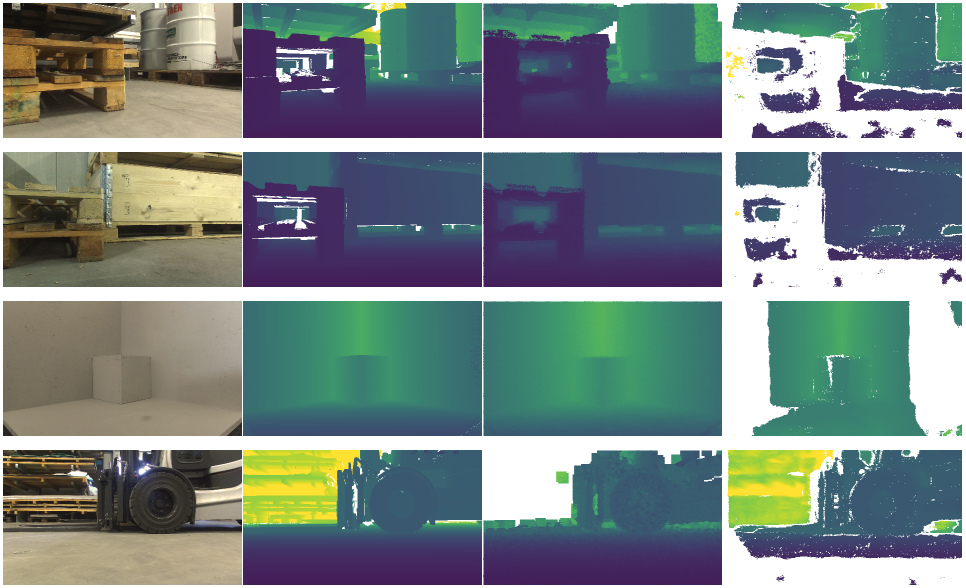

Der Datensatz hat 44 verschiedene Scans/Ansichtspunkte mit insgesamt 770 Einzelbildern. Beispiele der aufgenommenen Frames aus vier verschiedenen Szenen sind unten zu sehen. In den Spalten von links nach rechts wird das linke RGB-Bild, die Ground Truth, die ToF-Depth und die Stereo-Depth visualisiert.

Folgende Daten werden zur Nutzung veröffentlicht:

- ToF amplitude

- ToF depth & disparity

- RGB left & right

- Stereo depth & disparity

- Ground Truth depth & disparity

Der Datensatz ist in drei Auflösungen vorhanden, full, half, quarter und kann unter folgendem Link heruntergeladen werden:

https://datasets.rwu.de/3drobust_rwu3d

(Die Zugangsdaten können bei tobias.mueller@rwu.de angefragt werden)

Die Rohdaten vor der Interpolation können durch Kontaktaufnahme mit einem der Projektmitglieder (auf dem nebenstehenden Tab) zur Verfügung gestellt werden.

Projektpartner

|

ifm Unternehmensgruppe |

Fördergeber

|

Bundesministerium für Bildung und Forschung |

Projektteam

Projektleitung